深入研究数据:用于黑盒攻击的有效替代训练

摘要

深度模型在处理对抗样本时显示了它们的脆弱性。对于黑盒攻击,在无法访问被攻击模型的架构和权重的情况下,大家广泛聚焦于训练对抗攻击的替代模型的方法。以往的替代训练方法主要是基于真实训练数据或合成数据来窃取目标模型的知识,而没有探索什么样的数据可以进一步提高替代模型和目标模型之间的可转移性。本文中,我们提出了一种新视角的替代训练,聚焦于设计知识窃取过程中使用的数据分布。更具体地说,我们提出了一个多样化数据生成模块来合成具有广泛分布的大规模数据。我们还引入了对抗替代训练策略,以关注分布在决策边界附近的数据。这两个模块的结合可以进一步提高替代模型和目标模型的一致性,从而大大提高了对抗攻击的有效性。大量的实验证明了我们的方法在非定向和定向攻击设置下对最先进的竞争对手的有效性。我们还提供了详细的可视化和分析,以帮助理解我们方法的优势。

1. 介绍

尽管在大多数计算机视觉任务中取得了优异的性能,但深度神经网络(DNN)已被证明容易受到难以察觉的对抗噪声或扰动的影响。对抗样本的存在揭示了将DNN部署到现实世界应用中的重要安全风险。当前社区以白盒与黑盒的设置之分来研究对抗攻击(它们的差异在于是否能完全访问目标攻击模型)。事实上,由于白盒攻击所需的完整目标模型信息在现实世界的部署中是不可用的,本文聚焦于黑盒攻击,其通常只基于目标模型的标签或输出分数来生成对抗样本。通常,黑盒攻击包括基于分数的方法或基于决策的方法。然而,在这些攻击中,需要对目标模型进行雪崩式查询,这仍可能限制它们在现实情况下攻击DNN的可用性。

最近,替代训练的想法在黑盒攻击中得到了广泛的探索。通常情况下,该方法并不是直接生成对抗样本,而是训练一个替代模型,在相同的输入数据的查询下,做出与目标模型类似的预测。在一定数量的查询下,这种方法通常能够根据目标模型学习到替代模型。因此可以对替代模型进行攻击,然后可以转移到目标模型上。

从根本上说,替代模型试图通过给出输入数据和相应的查询标签来从目标模型中获取知识。而关键问题是,输入数据是否来自目标模型的训练数据?假设“是”的话,它确实简化了替代训练。然而,在许多现实世界的视觉任务中,收集真实的输入数据甚至是非平凡的。例如,人物照片和视频的数据受到非常严格的控制,个人数据的隐私在很多国家都受到法律的保护。此外,真实图像是最有效的替代训练数据吗?目标模型的训练数据确实有助于在原始任务上得到一个表现良好的替代模型,但其不能保证攻击从替代模型到目标模型的可转移性。为了提高替代训练中的攻击性能,有必要使替代模型和目标模型之间的决策边界距离最小化,这不仅需要大规模和多样化的训练数据,而且特别需要分布在决策边界附近的数据。

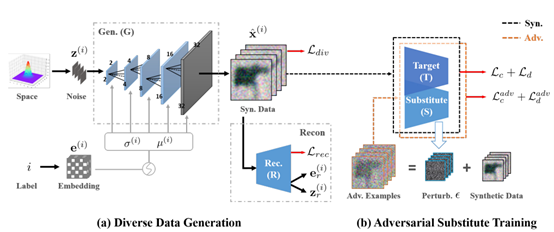

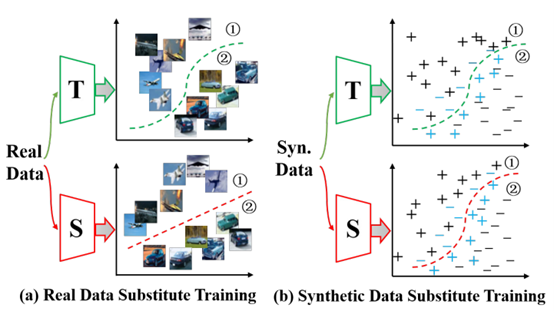

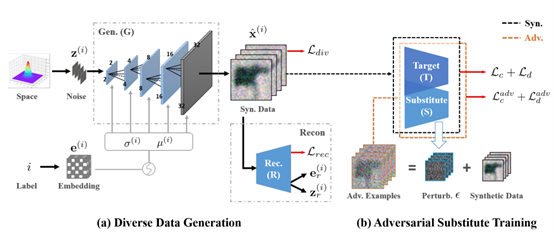

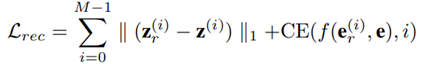

为了解决真实数据的局限性并探索替代训练数据的更好分布,我们提出了一种新颖的任务驱动统一框架,该框架仅使用专门设计的生成数据进行替代训练,并实现了高攻击性能。如图所示,与使用目标模型的训练数据进行替代训练相比,多样化的合成数据与对抗样本相结合,将促进替代模型进一步接近目标。更具体地说,在我们的框架中,我们首先提出了一个新颖的多样化数据生成模块(Data Generation module, DDG),该模块将噪声采样与标签嵌入信息相结合来生成多样化的训练数据。这样的分布式生成数据基本可以保证替代模型从目标中学习知识。此外,为进一步促使替代模型具有与目标相似的决策边界,我们提出了对抗替代训练策略(Adversarial Substitute Training strategy, AST),其将对抗样本作为边界数据引入训练过程。总的来说,DDG和AST的联合学习保证了替代模型和目标模型之间的一致性,这大大提高了在没有任何真实数据的情况下进行黑盒攻击的替代训练的成功率。

图1 将真实数据和合成数据应用于替代训练之间的差异。T/S表示目标/替代模型,(b)中的蓝色+/-表示对抗样本,绿色/红色虚线表示决策边界。比较(a)和(b)可以得到,我们的方法生成的合成数据可以训练一个与目标模型具有更相似决策边界的替代模型。

本工作的主要贡献总结为:(1)我们首次提出了一种新的基于有效生成的替代训练范式,其通过深入研究输入生成的替代训练数据的本质,来提高无数据黑盒攻击的性能。(2)为了实现这一目标,我们首先提出了一个具有多种不同约束的多样化数据生成模块,以扩大合成数据的分布。然后通过对抗替代训练策略进一步提高替代模型和目标模型之间决策边界的一致性。(3)对四个数据集和一个在线机器学习平台的综合实验和可视化证明了我们的方法相对最先进攻击的有效性。

2. 方法

2.1. 框架概述

我们工作的目标是为黑盒对抗攻击有效地训练替代模型,提出的框架如图所示。它由两个模块组成。多样化数据生成模块(DDG)产生多样化的数据,对抗替代训练策略(AST)进一步模仿目标模型的“行为”。在(a)中,DDG根据随机噪声z(i)和标签索引i的标签嵌入向量e(i)生成数据 。为了保证合成数据的多样性,生成器G通过三个约束进行训练,即自适应标签归一化生成器、噪声/标签重建和类间多样性,这将在后面详细说明。此外,为了确保替代模型S接近目标模型T的决策边界,我们将合成的数据和AST的对抗样本一起输入S以进行(b)中的替代训练。从本质上讲,我们把目标模型T作为分类为M类的黑盒,其中只有标签/概率输出可用。师生策略在这里被用于从T学习到S。最后,攻击可以在替代模型上进行,然后转移到目标模型上。

。为了保证合成数据的多样性,生成器G通过三个约束进行训练,即自适应标签归一化生成器、噪声/标签重建和类间多样性,这将在后面详细说明。此外,为了确保替代模型S接近目标模型T的决策边界,我们将合成的数据和AST的对抗样本一起输入S以进行(b)中的替代训练。从本质上讲,我们把目标模型T作为分类为M类的黑盒,其中只有标签/概率输出可用。师生策略在这里被用于从T学习到S。最后,攻击可以在替代模型上进行,然后转移到目标模型上。

图2 整体框架图示。其由多样化数据生成模块(DDG)和对抗替代训练模块(AST)组成。(a)DDG旨在生成具有给定标签的不同数据以训练替代模型。(b)AST利用从当前替代模型生成的对抗样本来推动替代模型模仿目标的边界。

2.2. 多样化数据生成

为了合成更好的数据用于替代训练,我们首先提出了一个新颖的多样性数据生成模块(DDG),该模块有三个约束条件来操纵生成的合成图像的多样性。这些约束条件原则上鼓励生成器G为每个不同的类学习相对独立的数据分布,并保持类间差异,从而促进替代模型学习目标模型的知识。

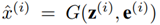

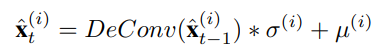

自适应标签归一化生成器。为了更好地从目标模型中学习,我们需要所有类别的平均分布数据进行替代训练,因此有必要生成标签控制的数据。为了实现这一点,我们充分利用了给定的标签和随机噪声。首先,通过从标准高斯分布和标签i中采样的随机噪声向量 的输入,我们计算出基于嵌入层的标签嵌入向量

的输入,我们计算出基于嵌入层的标签嵌入向量 。这种标签嵌入过程可以将单个离散标签编码为一个连续的可学习向量,它在特征空间中的分布更广,包含更多的表示信息。与GAN不同,我们没有使用真实的图像进行监督,这样的标签嵌入过程对数据的生成至关重要。接下来,我们通过两个全连接层从N维标签嵌入向量e(i)中提取平均值μ(i)和方差σ(i)。之后,将μ(i)和σ(i)加入到所有的反卷积块中,迭代合成具有特定类别条件的图像数据,可以表示为:

。这种标签嵌入过程可以将单个离散标签编码为一个连续的可学习向量,它在特征空间中的分布更广,包含更多的表示信息。与GAN不同,我们没有使用真实的图像进行监督,这样的标签嵌入过程对数据的生成至关重要。接下来,我们通过两个全连接层从N维标签嵌入向量e(i)中提取平均值μ(i)和方差σ(i)。之后,将μ(i)和σ(i)加入到所有的反卷积块中,迭代合成具有特定类别条件的图像数据,可以表示为:

其中总共有五个反卷积块,t表示反卷积块的数量。在获得最终的ˆx(i)之后,输出生成的数据已经被标签归一化的信息进行了修改。这种自适应标签归一化生成器可以更好地利用输入噪声和标签嵌入向量之间的关系来合成标签控制的数据。

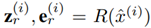

噪声/标签重建。为了进一步确保生成数据ˆx (i)的多样性,我们引入了一个重建网络R来重建输入噪声和标签嵌入 。而相应的重建损失可以计算为

。而相应的重建损失可以计算为

其中我们使用L1来表示输入z(i)和重建的z(i)r之间的差异。对于标签重建,我们应用函数f(∗)来计算e(i)r和e之间的余弦距离,并由Softmax进一步处理以计算与真实标签i的交叉熵损失。在这种约束下,G可以为每个类别的不同输入噪声向量生成更多样的图像。

类间多样性。为了进一步增强不同类别的数据多样性,我们使用余弦相似矩阵来最大化所有合成图像的类间距离。特别地,生成器生成一个MB≪M的不同类别的输入合成数据batch,模型S给出这个batch的输出相似度矩阵 。请注意,我们有真实的相似性矩阵

。请注意,我们有真实的相似性矩阵 ,除了对角线元素被设置为1,其他元素都是0。因此,多样性损失函数Ldiv可以表述为:

,除了对角线元素被设置为1,其他元素都是0。因此,多样性损失函数Ldiv可以表述为:

其中,TRI(∗)被定义为提取相似度矩阵中除对角线元素外的上三角元素的操作。通过这种方式,Ldiv确保合成数据拥有每个类别的独立分布。

2.3. 对抗替代训练

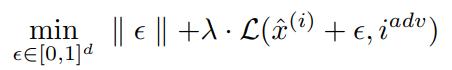

在DDG生成多样化的训练数据后,为了获得更好的攻击性能,我们还需要进一步鼓励与目标决策边界更相似的替代模型。众所周知,对抗样本拥有视觉上难以区分的扰动,其会被模型错误的分类。由于扰动相对较小,对抗样本可以看作是决策边界周围的样本。因此,我们提出了一种新颖的对抗替代训练策略(AST),它利用对抗样本进一步推动S的决策边界与T的决策边界相似。更具体地说,对于训练期间的每次迭代,我们的生成器首先通过DDG合成图像。然后我们选择白盒攻击算法来获得基于当前S的合成图像的对抗扰动ε。生成对抗图像的目标函数定义为

其中L(·) 表示攻击目标,反映了预测xˆ(i)+ε的标签为iadv的概率或交叉熵。如果考虑非定向攻击,则iadv≠i,否则iadv=t,t为目标标签。λ是正则化系数,约束ε∈[0, 1]d将扰动ε限制在有效图像空间内。然后,生成的图像和相应的对抗数据被用来一起更新S。

2.4. 损失函数

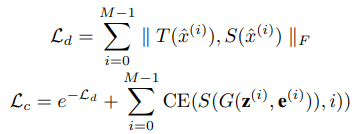

最后,我们应用基本损失函数来训练替代模型

其中Ld测量T和S输出之间的距离,Lc表示生成损失。e-Ld表示Ld的“最小-最大”博弈,CE(·)表示S的预测和输入的真实标签i之间的交叉熵损失。因此,凭借这两个损失函数的交替最小化,替代模型S可以学习模仿目标模型T的输出。在DDG和AST的进一步推动下,通过生成的数据和对抗样本,用于训练S和G的统一替代训练损失LS和生成器损失LG被定义为

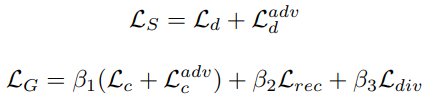

其中Ladvd的定义与等式中的Ld相同。之前的公式使用对抗样本作为输入测量T和S的输出间的距离,Ladvc被定义为Lc,以约束以对抗样本作为输入的生成,Lrec和Ldiv被用来增强数据多样性。β1、β2和β3是DDG的平衡超参数。总的来说,训练过程如下。

3. 实验

3.1. 实验设置

数据集和目标模型。1) MNIST:攻击模型在AlexNet、VGG-16和ResNet-18上进行预训练。默认的替代模型是具有3个卷积层的网络。2)CIFAR-10:攻击者在AlexNet、VGG-16和 ResNet-18上进行了预训练。默认替代模型是VGG-13。3) CIFAR-100:被攻击者在VGG-19和ResNet50上进行了预训练。默认的替代模型是ResNet-18。4)Tiny Imagenet:被攻击者在ResNet-50上进行了预训练。替代模型是ResNet-34。

比较对象。为了验证所提出方法的有效性,我们将我们的攻击结果与无数据黑盒攻击(如DaST)和几种需要真实数据的黑盒攻击(如PBBA和Knockoff)。我们还使用被攻击模型的原始训练数据进行替代训练,并利用ImageNet学习替代模型。

实现细节。我们使用Pytorch进行实现。我们利用Adam从头开始训练我们的替代模型、生成器和重建网络,所有权重都使用标准差为0.02的截断正态分布随机初始化。所有网络的初始学习率均设置为0.0001,从第80个epoch开始逐渐降低到0,并在第150个epoch后停止。我们将mini-batch大小设置为500,超参数β1、β2和β3值为1。我们的模型由一个 NVIDIA GeForce GTX 1080Ti GPU训练。我们应用PGD作为在AST和评估期间生成对抗图像的默认方法。我们还使用FGSM、BIM和C&W进行广泛实验的攻击。

评价指标。 考虑到 DaST中提出的存在两种不同的场景,即只从目标模型中获取输出标签并很好地访问输出概率,我们将这两种场景命名为基于概率和基于标签。在实验中,我们报告了由替代模型产生的对抗样本攻击目标黑盒模型的攻击成功率(ASRs)。按照DaST的设置,在非目标攻击设置中,我们只在被攻击模型正确分类的图像上生成对抗样本。对于目标攻击,我们只在没有被分类到特定错误标签的图像上生成对抗样本。为了公平比较,在所有的对抗样本过程中,设定扰动ε=8。我们对每个测试进行五次,并报告平均结果。

3.2. 黑盒攻击结果

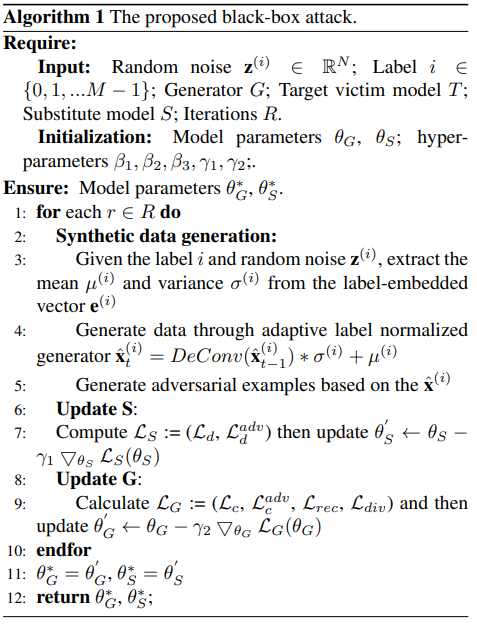

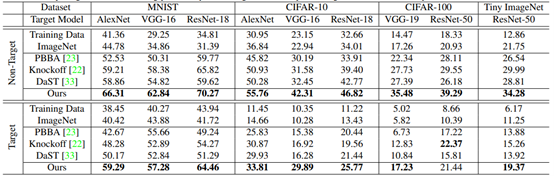

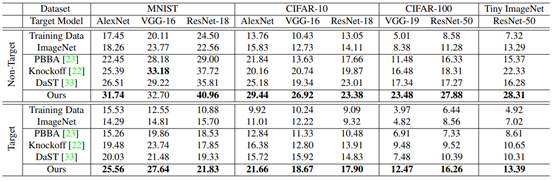

我们与比较对象手在四个数据集和一个在线机器学习平台上评估我们的方法,包括了定向攻击和非定向攻击设置。如表1、2、3所示,我们在基于概率和基于标签的场景下对每个数据集的多个目标模型进行了广泛的比较。

表1 使用概率作为我们的方法和比较对象在多个数据集上的目标模型输出来比较ASRs结果

表2 使用标签作为我们的方法和比较对象在多个数据集上的目标模型输出来比较ASRs结果

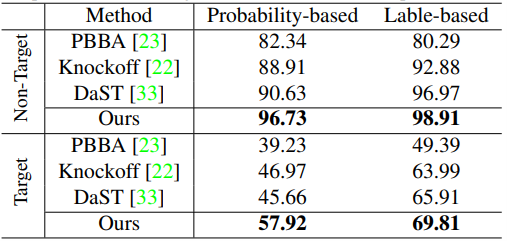

表3 比较攻击Microsoft Azure示例模型下我们的方法和比较对象的ASRs结果

与真实数据进行替代训练进行比较。这里我们研究了用真实图像进行攻击的替代训练,如表1和表2所示。我们直接使用目标模型或ImageNet的原始训练数据进行替代训练,而不是合成训练。结果显示,真实图像可以让替代模型从目标中学习到部分东西,在分类上可能会有更高的准确率,但与生成的数据相比,攻击强度较弱。我们认为,这个问题是由真实图像的数量和多样性限制造成的,这可能导致替代模型学习和模仿目标模型的失败。因此,我们提出了一种DDG策略来合成大规模和多样化的数据。

与最新方法的比较。如表1和表2所示,我们将我们的方法与黑盒攻击进行比较。对于定向攻击和非定向攻击,我们的方法在所有数据集下都取得了比基于概率和基于标签的方案更好的ASRs。此外,与相似的生成法DaST相比,我们的方法很大程度上优于它。这些结果验证了所提出的方法让替代模型更好地接近目标的决策边界和实现无数据黑盒攻击的高ASRs这两个方面的有效性。

在Microsoft Azure上与比较对象的比较。为了更好地评估实际应用下的攻击手段能力,我们在Microsoft Azure上进行了在线模型攻击实验。通过以攻击Azure上机器学习教程中的MNIST模型为目标,我们比较了我们的方法和竞争对手之间的结果。表3中显示的结果表明了我们的方法可以在在线模型上获得最好的ASR,这进一步证明了我们的方法在没有攻击先验知识的真实场景下的有效性。

4. 结论

本文重点研究黑盒攻击替代训练的生成数据的分布。它提出了一个统一的替代模型训练框架,包含一个多样化数据生成模块(DDG)和一个对抗替代训练策略(AST)。DDG可以生成标签控制的和多样化的数据来训练替代模型。AST利用对抗样本作为边界数据,使替代模型更好地符合目标的决策边界。大量实验表明该方法可以实现高攻击性能。